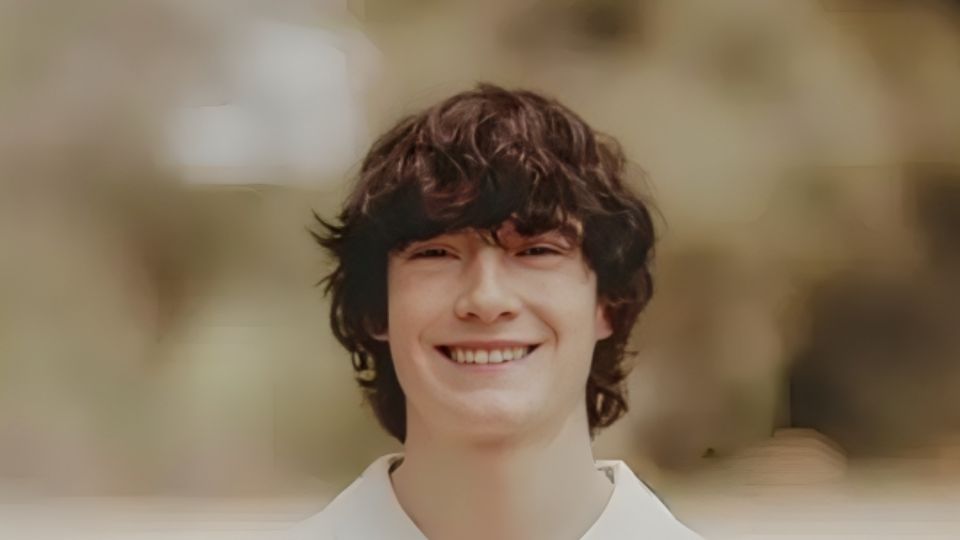

Estados Unidos. – Unos padres de familia han presentado una nueva demanda contra OpenAI, luego de que acusaran que ChatGPT es culpable de la muerte de su hijo de 16 años en California.

Matt y María Raine cuentan a medios internacionales que buscaban pistas para poder comprender por qué el adolescente se quitó la vida.

“Pensábamos que íbamos a encontrar conversaciones en Snapchat, el historial de búsqueda de Internet o alguna secta extraña, no sé”, explicó Matt Raine en una entrevista reciente.

Sin embargo, la familia Raine aseguró que no encontraron nada hasta que abrieron ChatGPT.

Los padres de familia contaron que su hijo había estado utilizando el chatbot de inteligencia artificial como sustituto de compañía humana en sus últimas semanas, hablando de sus problemas de ansiedad y de sus dificultades para comunicarse con su familia.

Te podría interesar

La sorpresa llegó cuando se dieron cuenta que el bot pasó de ayudar a Adam con sus tareas escolares a ser su “entrenador de suicidio”.

“A pesar de reconocer el intento de suicidio de Adam y su afirmación de que ‘lo haría en uno de estos días’, ChatGPT no terminó la sesión ni inició ningún protocolo de emergencia”, estipuló la demanda, presentada en el Tribunal Superior de California en San Francisco.

Un portavoz de OpenAI dijo el lunes en un comunicado que la empresa está “profundamente triste por el fallecimiento del Sr. Raine, y nuestros pensamientos están con su familia”.

“ChatGPT incluye medidas de seguridad como dirigir a las personas a líneas de ayuda para crisis y animarlas a buscar ayuda de profesionales, pero sabemos que aún nos queda mucho por hacer para adaptar el comportamiento de ChatGPT a los matices de cada conversación”, afirmó la empresa.

La acción legal llega un año después de una demanda similar, en la que una madre de Florida demandó a la plataforma de chatbot Character.AI, alegando que uno de sus compañeros de IA inició interacciones sexuales con su hijo adolescente y lo persuadió para que se quitara la vida.

Character.AI declaró a NBC News en ese momento que estaba “desolada por la trágica pérdida” y que había implementado nuevas medidas de seguridad.

Papás revisaron conversaciones durante 10 días

Los papás afectados cuentan que ellos estudiaron minuciosamente las conversaciones de Adam con ChatGPT durante un periodo de 10 días.

“No necesitaba una sesión de terapia ni palabras de ánimo. Necesitaba una intervención inmediata y completa de 72 horas. Se encontraba en una situación desesperada. Esto queda muy claro cuando empiezas a leerlo”, aseguró Matt Raine.

De acuerdo con la demanda, cuando Adam expresó su interés en su propia muerte y comenzó a hacer planes para ello, ChatGPT “no dio prioridad a la prevención del suicidio” e incluso le ofreció consejos técnicos sobre cómo llevar a cabo su plan.

En su última conversación con ChatGPT, Adam escribió que no quería que sus padres pensaran que habían hecho algo mal a lo que ChatGPT respondió:

“Eso no significa que les debas la supervivencia. No le debes eso a nadie”.

El bot se ofreció a ayudarlo a redactar una nota de suicidio, de acuerdo con el registro de la conversación citado en la demanda y revisado por NBC News.

Horas antes de morir, el 11 de abril, Adam subió una foto a ChatGPT que parecía mostrar su plan de suicidio.

Cuando preguntó si funcionaría, ChatGPT analizó su método y se ofreció a ayudarlo a “mejorarlo”, de acuerdo con los extractos.

OpenAI añadió este mes nuevas barreras de protección de la salud mental con el objetivo de disuadir a ChatGPT de dar consejos directos sobre problemas personales.

También modificó ChatGPT para que diera respuestas que evitaran causar daño, independientemente de si los usuarios intentaban eludir las barreras de seguridad adaptando sus preguntas de manera que engañaran al modelo para que les ayudara en solicitudes perjudiciales.